Nonostante i benefici che l’l’Intelligenza Artificiale (IA) può dare alla società, alla crescita economica e rafforzamento dell’innovazione dell’UE e della sua competitività a livello mondiale, la legge dell’UE (prima al mondo sull’IA), mira ad affrontare i rischi per la salute, la sicurezza e i diritti fondamentali.

Nonostante i benefici che l’l’Intelligenza Artificiale (IA) può dare alla società, alla crescita economica e rafforzamento dell’innovazione dell’UE e della sua competitività a livello mondiale, la legge dell’UE (prima al mondo sull’IA), mira ad affrontare i rischi per la salute, la sicurezza e i diritti fondamentali.

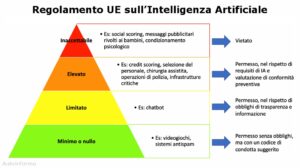

Il 1° agosto 2024 è entrato in vigore il nuovo Regolamento (UE) 2024/1689, noto come AI Act, che stabilisce norme armonizzate sull’intelligenza artificiale. Il quadro giuridico si applicherà sia agli attori pubblici che a quelli privati all’interno e all’esterno dell’UE. La legge sull’IA introduce un quadro uniforme in tutti gli Stati membri dell’UE, basato su un approccio fondato sul rischio:

- Rischio inaccettabile: Un insieme molto limitato di usi particolarmente dannosi dell’IA che violano i valori dell’UE in quanto violano i diritti fondamentali e saranno pertanto vietati:

- Sfruttamento delle vulnerabilità delle persone, manipolazione e uso di tecniche subliminali;

- Punteggio sociale per scopi pubblici e privati;

- Attività di polizia predittiva individuale basate unicamente sulla profilazione delle persone;

- Raschiatura non mirata di Internet o CCTV per immagini facciali al fine di creare o ampliare banche dati;

- Riconoscimento delle emozioni sul luogo di lavoro e negli istituti di istruzione, salvo per motivi medici o di sicurezza (ossia il monitoraggio dei livelli di stanchezza di un pilota);

- Categorizzazione biometrica delle persone fisiche per dedurre la razza, le opinioni politiche, l’appartenenza sindacale, le convinzioni religiose o filosofiche o l’orientamento sessuale. L’etichettatura o il filtraggio delle serie di dati e la categorizzazione dei dati nel settore delle attività di contrasto saranno ancora possibili;

- Identificazione biometrica remota in tempo reale in spazi accessibili al pubblico da parte delle autorità di contrasto, fatte salve limitate eccezioni (cfr. infra).

- La Commissione pubblicherà orientamenti sui divieti prima della loro entrata in vigore il 2 febbraio 2025.

- Rischio alto: Un numero limitato di sistemi di IA definiti nella proposta, che potrebbe avere un impatto negativo sulla sicurezza delle persone o sui loro diritti fondamentali (tutelati dalla Carta dei diritti fondamentali dell’UE), è considerato ad alto rischio. Sono allegati alla legge gli elenchi dei sistemi di IA ad alto rischio, che possono essere riesaminati per allinearsi all’evoluzione dei casi d’uso dell’IA.

- Tali sistemi comprendono inoltre i componenti di sicurezza dei prodotti disciplinati dalla legislazione settoriale dell’Unione, Saranno sempre considerati ad alto rischio quando sono soggetti a una valutazione della conformità da parte di terzi ai sensi di tale legislazione settoriale.

- Tali sistemi di IA ad alto rischio comprendono, ad esempio, sistemi di IA che valutano se qualcuno è in grado di ricevere un determinato trattamento medico, ottenere un determinato lavoro o un prestito per acquistare un appartamento. Altri sistemi di IA ad alto rischio sono quelli utilizzati dalla polizia per profilare le persone o valutarne il rischio di commettere un reato (a meno che non siano vietati a norma dell’articolo 5). E ad alto rischio potrebbero essere anche i sistemi di IA che gestiscono robot, droni o dispositivi medici.

- Rischio specificoper la trasparenza: Per promuovere la fiducia, è importante garantire la trasparenza sull’uso dell’IA. Pertanto, la legge sull’IA introduce requisiti specifici di trasparenza per determinate applicazioni di IA, ad esempio laddove vi sia un evidente rischio di manipolazione (ad esempio attraverso l’uso di chatbot) o deep fake. Gli utenti dovrebbero essere consapevoli del fatto che stanno interagendo con una macchina.

- Rischio minimo: La maggior parte dei sistemi di IA può essere sviluppata e utilizzata nel rispetto della legislazione vigente senza ulteriori obblighi giuridici. I fornitori di tali sistemi possono scegliere di applicare, su base volontaria, i requisiti per un’IA affidabile e aderire a codici di condotta volontari.

Inoltre, la legge sull’IA prende in considerazione i rischi sistemici che potrebbero derivare dai modelli di IA per finalità generali, compresi i grandi modelli di IA generativa. Che possono essere utilizzati per una serie di compiti e stanno diventando la base di molti sistemi di IA nell’UE. Alcuni di questi modelli potrebbero comportare rischi sistemici se sono molto capaci o ampiamente utilizzati. Ad esempio, modelli potenti potrebbero causare incidenti gravi o essere utilizzati impropriamente per attacchi informatici di vasta portata.

Per comprendere a fondo ed applicare le disposizioni del regolamento scaricate e leggete l’allegato documento .pdf con chiarimenti sotto forma di domande e risposte.